Retour sur le séminaire consacré aux sondages d'intentions de vote

Publié par Guillaume Main dans le dossier Analyse | 22 mars 2012

Lorsqu'on revendique un domaine de prédilection comme je le fais avec les statistiques, il me paraît toujours nécessaire, ne serait-ce que pour dégourdir l'esprit, de se replonger un peu dans la théorie et de se remémorer les bonnes pratiques. Aussi, rencontrer des gens souvent bien plus aguerris que moi sur la question des sondages d'intentions de vote m'apparaissait comme une expérience incontournable.

L'occasion m'en était donné grâce à Bruno Jeanbart (OpinionWay) qui me transmettait une invitation à un séminaire traitant du "Bon usage des sondages d’intentions de vote".

Se tenant dans un amphithéâtre de l'Institut Henri Poincaré, plusieurs acteurs majeurs des statistiques et des sondages étaient présents dans l'amphi : je ne citerais dans un premier temps que la SFdS (Société Française de Statistique) et le CEVIPOF (Centre de recherches politiques de Sciences Po), tous deux organisateurs du séminaire. Sans faire de jeunisme primaire, j'avoue que la moyenne d'âge m'a particulièrement surpris. Et bien qu'on se soit parfois cru dans l'hémicycle du Sénat, le contexte avait au moins l'avantage de me rappeler le charme et l'atmosphère boisée de mes années d'étude déjà lointaines. Je vais donc essayer de dresser un compte rendu de ce séminaire, lequel, s'il n'est pas exhaustif sera en tout cas sans la moindre langue de bois.

La méthodologie des sondages et des estimations d’intentions de vote

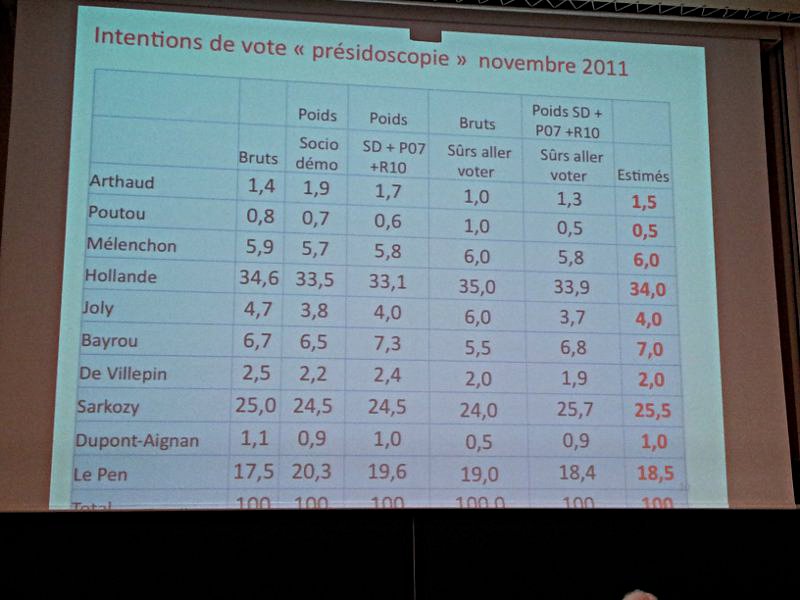

Introduit par Benoît Riandey (INED et SFdS), le premier intervenant est Jean Chiche (CEVIPOF et SFdS). L'objectif est ici de nous rappeler les différentes formes que peuvent prendre les sondages d'intentions de vote : les enquêtes pré-électorales, les rolling pools (sondages "glissants"), les enquêtes sur panel, de sortie des urnes, les estimations électorales, le comptage des suffrages dépouillés ou encore les études comparatives post-électorales. Puis Jean Chiche nous présente l'étude "Présidoscopie" réalisée en novembre 2011 afin d'entrer dans le vif du sujet avec les notions de pondération, de données socio-démographiques (SD). Il s'agit de mesurer les intentions de vote sur la base des individus "sûrs d'aller voter".

Plusieurs pondérations sont envisagées : le poids des données SD, des données issues de la Présidentielle 2007 (P07) et de celles issues des Régionales 2010 (R10). Il est intéressant de constater l'écart entre les données brutes de l'échantillon global et l'estimation finale (arrondie à 0.5 près) sur la base des sondés "sûrs d'aller voter". L'intervenant insiste bien sur l'absence totale de considération politologique dans la prise en compte et l'affectation des pondérations. Par ailleurs, il est affirmé qu'aucune différence significative n'est observée entre le mode de recueil téléphonique et le mode de recueil en ligne.

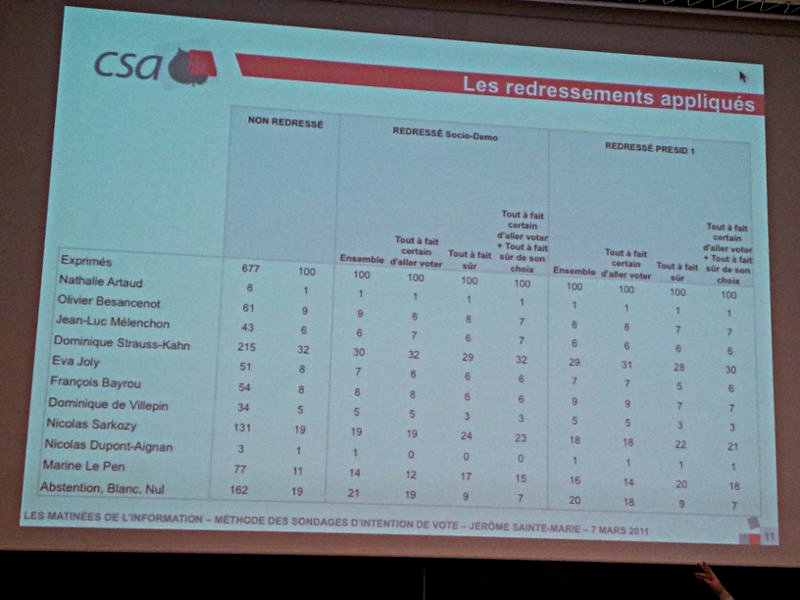

Le second intervenant est Jérôme Sainte-Marie (directeur général adjoint de l'institut CSA). Avec son exposé, l'accent est mis sur les sondages d'intentions de vote dont le mode de recueil est le téléphone. Jérôme Sainte-Marie évoque un paradoxe dans la recherche de la bonne mesure et pour faire une analogie, il affirme que les sondés ont une intention de vote qui peut se matérialiser de trois façons différentes : l'état solide (intention concrète d'aller voter motivée par un intérêt pour la chose politique), l'état liquide (intention d'aller voter mais sans assurance sur le choix du candidat) et l'état gazeux (versatilité totale de l'intention de vote). Puis l'intervenant nous soumet un tableau de résultats (étude du 7 mars 2011) montrant les pondérations appliquées et les différentes bases d'individus ("tout à fait certain d'aller voter", "tout à fait sûr de son choix", et la consolidation des deux notions).

La première partie du tableau montre les résultats redressés sur la base des données socio-démographiques et la seconde partie du tableau sur la base des données issues des résultats de la précédente élection présidentielle. Dans la pratique, Jérôme Sainte-Marie affirme que selon CSA, l'élection de référence offrant le meilleur redressement est celle des Législatives 2007. Par ailleurs, il insiste bien sur l'idée que le taux de reconstitution de l'électorat de Marine Le Pen (à partir de celui de Jean-Marie Le Pen) est aujourd'hui très fort. Nous ne sommes donc plus du tout dans la situation de 2002 : le 21 avril 2002, la mesure brute de Le Pen était de 7% et il allait faire 16.9%, tandis que le 22 avril 2007, la mesure brute était également de 7% et il allait faire 10.4%. Cette anecdote montre à quel point la proposition de publier les résultats bruts est une hérésie.

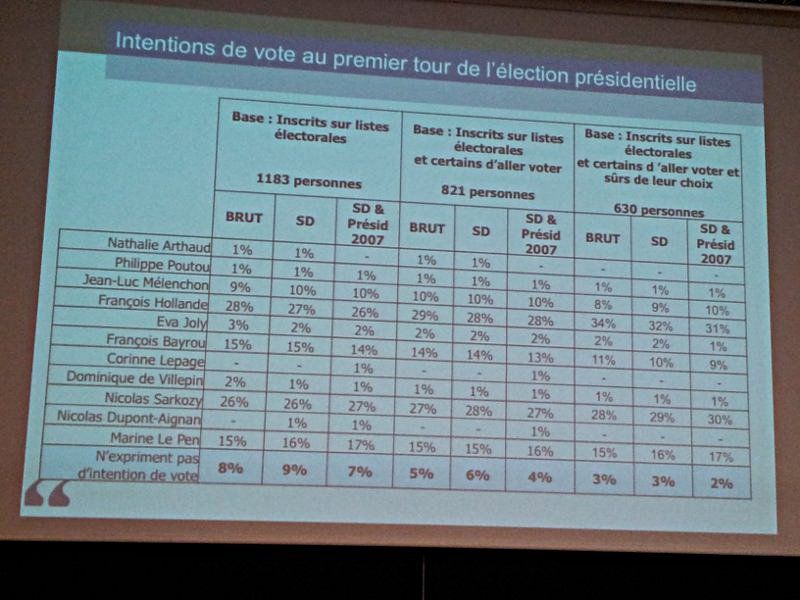

Bruno Jeanbart (directeur des études politiques d'OpinionWay) est le troisième intervenant. Il affirme que les méthodes utilisées par les instituts de sondage est véritablement calibrée et utilisée dans de très nombreux contextes (qui dépassent les sondages d'intentions de vote). Il rappelle par ailleurs que, par définition, la base des sondés répondant à la question du souvenir de vote est nécessairement tronquée puisque les échantillons contiennent forcément de nouveaux électeurs n'ayant pas voté aux précédentes élections. Il est cette fois question d'enquêtes auto-administrées par Internet. Bruno Jeanbart nous propose deux tableaux : le premier compare les résultats bruts aux résultats réels et le second compare les résultats bruts aux résultats redressés pour l'élection présidentielle de 2007, puis celle de 2002. Puis on découvre enfin un tableau consacré à la dernière étude OpinionWay concernant celle de 2012.

La méthode utilisée est entièrement comparable à celle de CSA, mais Bruno Jeanbart insiste sur le fait qu'OpinionWay utilise toujours les données de redressement de la même élection présidentielle et éventuellement, ajoute la dernière élection nationale (comme les Régionales 2010 actuellement). Il s'agit donc bien de toujours s'en tenir aux mêmes données de redressement sur l'ensemble des mesures d'une année électorale. Par ailleurs, bien que la mesure des intentions de vote à l'occasion des primaires socialistes ait été une discipline inédite, Bruno Jeanbart explique que les résultats ont été immédiatement satisfaisants car la part des sympathisants de gauche certains d'aller voter était très forte : l'ordre des candidats a en tout cas toujours été respectés.

Durant cette première phase de débat, Jérôme Sainte Marie réitère l'idée selon laquelle les instituts font de l'analyse de tableaux de résultats. Aucune politologie intervient dans la mesure et dans la restitution des résultats. Il ajoute qu'en 2002, les politologues excluaient totalement l'hypothèse de voir Jean-Marie Le Pen dépasser la barre des 10%. Inversement, en 2007, ces mêmes politologues accusaient les instituts de n'avoir rien appris de leurs erreurs et pensaient que le score de Le Pen était lourdement sous estimé. Bruno Jeanbart fait ensuite état du fameux sondage de l'institut qu'on-ne-nomme-pas (Harris Interactive) qui plaçait Marine Le Pen au second tour des futures Présidentielles dès mars 2011, et dans tous les cas de figure (avec 20% d'intention de vote). Quelques jours plus tard, OpinionWay réalisait un sondage dans lequel Marine Le Pen affichait un résultat brut de 35% : devant le caractère improbable du résultat, il était finalement décidé de ne pas exploiter le sondage. Par ailleurs, Bruno Jeanbart explique que dans un premier temps, entre 2006 et 2007, OpinionWay ne publiait aucune études en ligne d'intention de vote : il était d'abord nécessaire d'apprendre à identifier les biais et les difficultés en tout genre posées par ce mode de recueil auto-administré. Enfin, pour illustrer les considérables progrès effectués dans la mesure d'intention de vote, Bruno Jeanbart évoque les chiffres des Municipales 2001 présentant des décalages parfois extrêmement forts sur Paris notamment.

Afin de démystifier une polémique récurrente liée aux échantillonnages, je soumets une question. Comme les méthodes d'échantillonnage utilisées en institut de sondage sont généralement non probabilistes (puisque reposant sur des quotas), je souhaitais savoir ce que vaut le calcul des marges d'erreur dans ce contexte. Ne recevant pas un grand succès avec ma question, elle sera d'abord éludée, puis finalement reposée en fin de séminaire par un sympathique professeur de statistique de Bordeaux. Par la suite, je dois admettre m'être retrouvé un poil largué sur la notion "d'échantillon post-stratifié à probabilité inégale" (évoqué comme étant particulièrement efficace pour la mesure d'intentions de vote du second tour). D'autre part, Jérôme Sainte Marie pose simplement la question de la validité de la méthode du pivot de Gauss (dont je garde un souvenir ému d'étudiant) sur des données redressées. Enfin, je n'ai pas eu le temps de poser une question sur les difficultés rencontrées lors de la primaire d'EELV.

La communication et l'utilisation des sondages d'intentions de vote

Introduite par Jean-François Royer (SFdS), la deuxième moitié du séminaire débute avec une première série d'interventions traitant de la médiatisation et de l'utilisation des sondages d'intention de vote. Thierry Vedel (CEVIPOF) ouvre la marche avec une rétrospective des sondages depuis Gallup et montre une couverture de The Literary Digest se plantant copieusement sur les intentions de vote de l'élection de 1936 entre Landon et Roosevelt. Pour illustrer l'assurance des candidats à la présidentielle, Thierry Vedel évoque le fait qu'en 2002, toutes les salles de meeting de l'entre deux tours étaient déjà réservées par le candidat Jospin. En 1965, 14 sondages étaient consacrés à la Présidentielle. Aujourd'hui, on en dénombre plus de 300. Puis pour illustrer les controverses provoquées par les sondages d'intention de vote, Thierry Vedel évoque les sondages contradictoires réalisées en pleine polémique sur les Roms (2010), le sondage Harris Interactive plaçant Marine Le Pen au second tour (2011), et plus récemment le croisement des courbes Sarkozy et Hollande (2012).

La suite du séminaire prend enfin l'aspect d'une table ronde consacrée à la communication des sondages d'intention de vote, animée notamment par Marie-Eve Aubin (Présidente de la Commission des sondages) et Daniel Boy (CEVIPOF). Je dois avouer que les interventions de la présidente de la Commission des sondages m'ont un peu laissé perplexe d'autant qu'elle entame son discours en précisant qu'elle n'est compétente ni en statistique, ni en technique d'élaboration de sondage. Du coup, les méthodes d'évaluation de la validité des sondages telles qu'elles sont exposées par Marie-Eve Aubin semblent singulièrement manquer de matière. Elle affirme par la suite qu'il n'y a que très peu de concurrence sur le marché des instituts de sondage (ce qui est pourtant largement discutable), et balance régulièrement des pavés dans la mare, du type : "... même si je ne comprends pas toujours pourquoi Mélenchon bénéficie d'un traitement de faveur dans certains sondages ! (rires)" (en réalité, comme le Front de Gauche ne possède pas d'historique en matière d'élection présidentielle, il est nécessaire d'appliquer la pondération des régionales 2010 puisque celle de la présidentielle 2007 n'a pas lieu d'être). En fait, pour expliquer ce décalage de perception, il faut bien comprendre que les membres de la Commission des sondages sont essentiellement des magistrats professionnels désignés par décret et sont donc particulièrement compétents en droit administratif (on y retrouve par exemple Mireille Imbert-Quaretta qui est par ailleurs présidente de la commission de protection des droits de l'HADOPI). Pour l'aspect technique de sa mission, la Commission des sondages est toutefois secondée par des experts indépendants auprès de la commission.

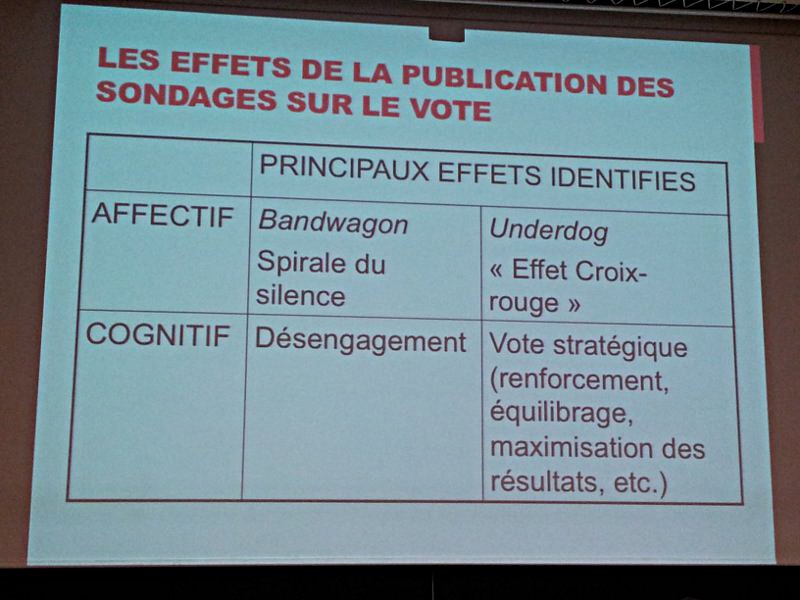

Et l'un d'eux, en la personne de Daniel Bachelet, était présent dans l'amphi aujourd'hui. Particulièrement didactique et précis, l'expert revient sur la problématique des marges d'erreur auxquelles il faudrait idéalement ajouter le biais. Son intervention découlait d'une question posée par Michel Lejeune, ancien professeur de statistique à Grenoble (à l'issue de ce séminaire, il semblait tout de même se montrer nettement moins critique que ce que laisse supposer cette vidéo). Les différentes interventions au cours de la table ronde sont enrichissantes. Il est notamment question des sphères dans lesquelles évoluent chacun des acteurs de la statistique : il y a les mondes médiatique, politique et universitaire, et les instituts de sondage. Chacun voit le problème du petit bout de sa lorgnette, rendant particulièrement compliqué la mise en place des solutions envisageables. Ont également été évoqués les polémiques relatives à la rémunération des internautes panélistes : il faut savoir que chez OpinionWay par exemple, les sondés ne sont interrogés en moyenne qu'une fois par mois et qu'ils reçoivent un euro pour 25 minutes de sondage. On a aussi parlé des électeurs "stratèges", ces quelques électeurs qu'on découvre lors des enquêtes qualitatives au cours desquelles ils expliquent qu'ils choisissent de déclarer une fausse intention de vote dans l'hypothèse de pouvoir déclencher une réaction auprès des autres électeurs.

Une autre de mes questions reste sans réponse : elle est consacrée à l'influence des médias sur les résultats de la mesure. Comme nous avions vu que la médiatisation du sondage Harris Interactive (Le Pen à 20%) semblait objectivement avoir eu une conséquence directe sur les intentions de vote d'un autre sondage OpinionWay réalisé quelques jours plus tard (Le Pen à 35% en brut), je me demandais comment on pouvait s'assurer que la médiatisation récente du resserrement des intentions de vote pour les candidats Sarkozy et Hollande n'avaient pas eu pour conséquence de provoquer le fameux "croisement des courbes". En somme, les médias auraient tendance à amplifier un phénomène mesuré par les instituts de sondage, lequel serait de nouveau amplifié par la médiatisation. Cette amplification serait ensuite mesurée par les instituts, et ainsi de suite. Le cercle est d'autant plus vicieux qu'en réalité, en tenant compte des marges d'erreur, les deux candidats sont à égalité depuis plusieurs semaines. Mon analyse a été balayée d'un revers de la main par Jean-François Royer, résumant cela à une théorie de la manipulation (ce que j'ai tenté de contredire, en vain). En définitive, le problème de la médiatisation des sondages n'a été qu'effleurée, mais je n'ai pas su identifier s'il était plutôt sous estimé ou étouffé.

En conclusion, je dois dire que j'ai été convaincu par les présentations de Jean Chiche, Jérôme Sainte Marie et Bruno Jeanbart, ainsi que par les explications statistiques de Daniel Bachelet, mais également par les craintes légitimes évoquées par Michel Lejeune. Pour autant, et compte tenu des grandes forces en présence (SFdS, CEVIPOF, professeurs d'université, commission des sondages), je m'attendais à bien plus de polémiques à l'encontre des représentants des instituts de sondage quant à leurs méthodes d'échantillonnage. Du reste, cela m'a permis d'évaluer à sa juste valeur le crédit porté aux thèses de ce que je surnomme le lobby anti-sondage français. Je note enfin que le séminaire a également été pour moi l'occasion de croiser Emmanuel Riviere et Carine Macé (TNS SOFRES), ainsi que d'échanger quelques mots avec Avner Bar-Hen et Jean-Michel Poggi (ex-président et président de la SFdS).

Moins de 5% des entreprises respectent les critères importants pour leur site

Moins de 5% des entreprises respectent les critères importants pour leur site TextMaster compte les fautes d'orthographe dans ses emails et en fait une étude

TextMaster compte les fautes d'orthographe dans ses emails et en fait une étude 5 exemples de l'impact d'une émission de télévision sur le trafic Web

5 exemples de l'impact d'une émission de télévision sur le trafic Web ElectionScope : que penser du modèle prédictif qui voit Sarkozy l'emporter ?

ElectionScope : que penser du modèle prédictif qui voit Sarkozy l'emporter ?

Derniers commentaires

Chat gratuit, le 22 mai 2013

5 exemples de l'impact d'une émission de…

Livef1.fr, le 18 mars 2013

5 exemples de l'impact d'une émission de…

cartoon network, le 18 mars 2013

10 façons de mesurer l'audience d'un…

Victoire, le 16 mars 2013

[INTERVIEW] Le métier de consultant en…

job bruxelles, le 13 mars 2013

[HUMEUR] Règle d'or : n'attendez jamais…

Weesifi, le 04 mars 2013

Comment identifier vos éventuels…

Séduction, le 24 décembre 2012

5 exemples de l'impact d'une émission de…

MarocEmploi, le 21 décembre 2012

Quelques observations sur le tracking…