Présidentielles 2012 : l'importance du calcul des marges d'erreur

Publié par Guillaume Main dans le dossier Analyse | 14 mars 2011

Un seul sondage consacré aux élections présidentielles de 2012 a suffit à mettre le feu au poudre. Réalisé par Harris Interactive et commandité par Le Parisien, il était publié en début de semaine dernière. Pourtant, en s'y penchant d'un peu plus près, on constate que ce sondage est paradoxalement d'une platitude absolue. En effet, en prenant toutes les précautions d'usage, il est difficile d'en tirer le moindre enseignement. Mais pour cela, encore faudrait-il que les journalistes s'intéressent aux marges d'erreur...

En tout cas, ce débat s'effectue dans un climat absolument déplorable. Comme le souligne Virginie Martin sur Rue 89, ce sondage taxé de non scientifique, non fiable, malhonnête et de coup de pub a provoqué une levée de boucliers aussi insensée que démesurée. L'analyse des journalistes se révèle au ras des pâquerettes, tandis que le lobby anti-sondage mené par quelques sociologues politiques se déverse jusque sur Agora, ou plus grave, sur Wikipedia dont la page "sondage d'opinion" est un cas d'école de propagande.

Pourtant, certains journalistes, extrêmement rares, cherchent encore à comprendre le pourquoi du comment : c'est notamment le cas de Steve Jambot qui me contactait à ce sujet pour une interview publiée sur France 24. Alors, on prend le temps d'expliquer (en particulier la méthodologie) et on tente de recontextualiser le débat. Dans ces cas là, j'ai remarqué que les journalistes tentent à tout prix de vous soutirer un aveu de faiblesse. Lancés dans une quête sans fin du biais absolu, ils cherchent vainement à pointer du doigt tout, et, je vous assure, vraiment n'importe quoi. L'an dernier, j'étais notamment invité dans les locaux de France 3 pour parler biais et méthodologie de sondage avec une journaliste : cette dernière n'ayant pas obtenu le croustillant escompté, l'entretien fut classé sans suite.

L'analyse de sondage pour les nuls

Lorsqu'on souhaite se faire une idée objective de la réalisation d'un sondage, que la méthodologie paraisse scabreuse ou non, le point de départ incontournable est évidemment le rapport de l'institut de sondage : à minima, on prend ainsi déjà connaissance de l'ensemble des quotas retenus, de la taille de l'échantillon, du mode de recueil, des dates du terrain, et de la formulation exacte des questions. Ainsi s'affranchit-on d'emblée des douteux raccourcis parsemant le papier du journaliste.

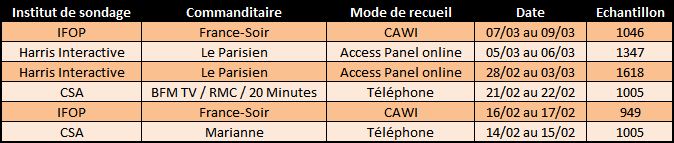

Sur cette base, je me suis intéressé à six sondages, réalisés sur six périodes différentes, par trois instituts, pour quatre commanditaires, selon trois modes de recueil, exploitant six échantillons de taille variée et passant en revue neuf candidats (quatre alternatives PS, quatre alternatives UMP et la candidate du FN).

- Institut IFOP pour France-Soir - Mars 2011 | rapport PDF

- Institut Harris Interactive pour Le Parisien - Mars 2011 | rapport PDF

- Institut Harris Interactive pour Le Parisien - Février / Mars 2011 | rapport PDF

- Institut CSA pour BFM TV / RMC / 20 Minutes - Février 2011 | rapport PDF

- Institut IFOP pour France-Soir - Février 2011 | rapport PDF

- Institut CSA pour Marianne - Février 2011 | rapport PDF

Voici le tableau récapitulatif (les sondages sont triés en fonction de la date du terrain) :

Retrouvez tous les tableaux de l'analyse dans le document Excel disponible ici

En s'intéressant à toutes les combinaisons testées par les instituts de sondage, on constate, contrairement à ce qui a été dit, que les commanditaires sont parfaitement enclins à interroger les français sur tous les candidats potentiels à l'élection présidentielle de 2012. Les méthodes utilisées sont différentes car dictées par leurs propres contraintes budgétaires et de temps. Par ailleurs, l'échantillon final respecte les quotas habituels pour ce type d'étude (sexe, âge, catégorie professionnelle, région, catégorie d'agglomération, nombre de personnes au foyer, inscription sur les listes électorales, et pour certains, vote au premier tour de l'élection présidentielle en 2007).

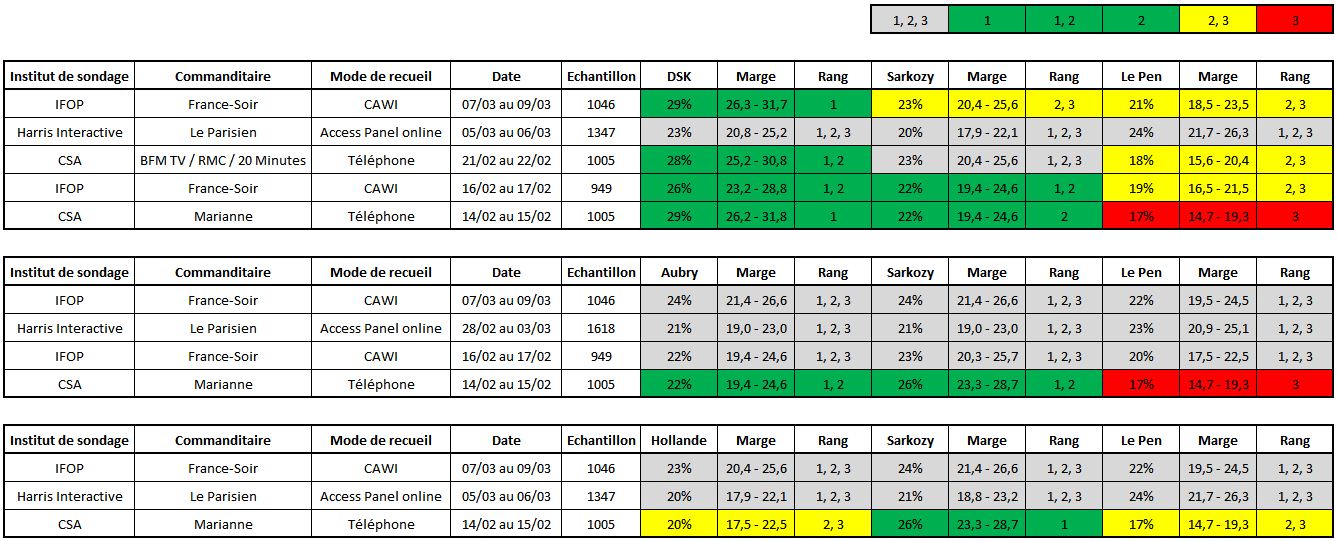

Focus sur les trois combinaisons les plus testées

De fait, ces deux derniers mois, les combinaisons DSK - Sarkozy - Le Pen (cinq fois), Aubry - Sarkozy - Le Pen (quatre fois) et Hollande - Sarkozy - Le Pen (trois fois) ont été les plus testées par les médias. De fait également, les candidats Royal, Copé, Fillon et Borloo n'ont été testés que dans un ou deux sondages, n'offrant qu'une maigre batterie de résultats.

Voici donc le tableau récapitulatif de ces trois principales combinaisons, auxquelles j'ai ajouté la marge d'erreur et en fonction de celle-ci, le rang d'arrivée du candidat.

La marge d'erreur (ou intervalle de confiance) est une notion facile à appréhender : théoriquement, elle dépend de la taille de l'échantillon, de la taille de la population totale et des pourcentages obtenus sur la question posée. Comme nous interrogeons moins de 10% de la population française votant à l'élection présidentielle, la taille de la population totale est une information non déterminante. J'en profite pour vous signaler l'excellent article sur les marges d'erreur publié par l'auteur du blog "Le Monde des Etudes". De plus, vous y trouverez une feuille Excel facilitant et automatisant le calcul des intervalles de confiance.

L'importance de la prise en compte de la marge d'erreur

Les différentes couleurs utilisées dans les trois tableaux dépendent directement de la marge d'erreur. Or, ces marges d'erreur peuvent se chevaucher, et c'est même très souvent le cas. C'est pourquoi le vert correspond aux candidats qui seraient qualifiés pour le second tour des présidentielles (1ère ou 2ème place), le jaune correspond aux candidats en balotage (2ème ou 3ème place), le rouge correspond aux candidats non qualifiés pour le second tour (3ème place). Enfin, le gris traduit une incertitude globale, les trois intervalles de confiance se chevauchant mutuellement (1ère ou 2ème ou 3ème place).

Comme je l'évoquais en introduction, le sondage Harris Interactive réalisé les 5 et 6 Mars ne permet pas de départager un second tour puisque la marge d'erreur se révèle trop large pour permettre à l'un ou l'autre de se distinguer de ces opposants. En clair, avec un échantillon de 1347 individus, si 24% des sondés répondent "Le Pen" à la question, alors on est sûr à 95% que le pourcentage d'individus répondant "Le Pen" à cette même question est compris entre 21.7 et 26.3%.

Si on parcourt les différents tableaux, tout candidat confondu et en prenant en compte les marges d'erreur, on constate en réalité que les sondages qualifient 4 fois sur 5 le candidat DSK, 1 fois sur 4 la candidate Aubry, 0 fois sur 4 le candidat Hollande, 4 fois sur 12 le candidat Sarkozy et... 0 fois sur 12 la candidate Le Pen pour le second tour des présidentielles. Mais surtout, on constate que la moitié des sondages (6/12) ne permettent de départager aucun des trois candidats.

Aussi, quand un blogueur comme Diego-San se permet une longue tirade dénonçant l'invalidité du sondage Harris Interactive sans évoquer ce point essentiel et central des intervalles de confiance, cela me fait réfléchir sur la pertinence du reste de son propos.

La valse des biais qui n'en sont pas

- Le type de recueil ?

Quitte à contredire sa consœur journaliste de Rue 89, Jacques Le Bohec fait parti de cette caste de professeurs martelant que les instituts de sondage s'approprient leur désignation "d'institut" de manière fallacieuse, que les sondages ne rendent services qu'aux gens dominants, que leurs arguments sont à ce point pertinents qu'ils annihilent toute autre forme possible de débat sur le sujet etc... Le site de l'Observatoire des sondages constitue d'ailleurs un de leurs quartiers généraux (vous constaterez au passage que les articles du site sont bien évidemment fermés aux commentaires). Or, cette poignée de détracteurs dénonce en particulier le mode de recueil en ligne sans toutefois ne jamais accompagner leurs accusations de la moindre démonstration.

Pourtant, ce mode de recueil subit aujourd'hui les critiques essuyées en leur temps par tous les autres modes de recueil, en particulier le recueil téléphonique (devenu finalement entre temps une méthodologie tout à fait acceptable). Le recueil online a été maintes fois décrits sur Statosphere mais une piqure de rappel ne fait pas de mal : comme tout autre recueil existant à ce jour, il présente des difficultés de représentativé au niveau des classes les plus âgées (d'où l'intérêt d'un quota d'âge) et des zones rurales (d'où l'intérêt d'un quota de catégorie d'agglomération). En fait, le principe d'un Access Panel garantit un vivier d'individus suffisamment important pour pouvoir représenter toutes les sous-couches d'une population et ainsi, respecter les quotas initiaux : si une cible est difficile à atteindre, alors on la sur-représente dans l'Access Panel afin que l'échantillon puisse être tiré sans difficulté et selon les données de cadrage fournies par l'INSEE.

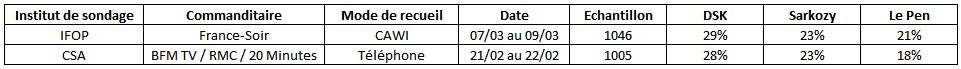

Profitons-en pour glisser un exemple parmi tant d'autres : la comparaison de l'étude téléphonique de CSA (21-22/02) avec l'étude en ligne de l'IFOP (07-09/03) montrent une forte similitude dans les résultats.

Aussi, doit-on considérer arbitrairement que la proximité des résultats n'est que le fruit du hasard ? Doit-on rappeler que le recueil téléphonique induit lui aussi des biais (sous-représentation des jeunes générations n'ayant plus de téléphone fixe, sur-représentation des inactifs etc...) ? Et enfin, messieurs les détracteurs, à quand une démonstration statistique de l'inefficacité du mode de recueil sur Internet ?

- Un effet de "calendrier" ?

Cela ferait effectivement appel au bon sens : la comparaison de deux sondages réalisés à plusieurs mois d'écart compromet sérieusement l'analyse. Dans le cas présent, il est question de trois semaines d'écart, maximum. Relativisons d'ailleurs ce point puisque l'élection présidentielle de 2012 aura lieu dans plus d'un an...

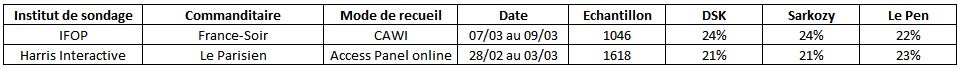

Tous ces sondages montrent clairement une absence de remou malgré le tumulte suscité par le sondage Harris Interactive : à la lecture des nouveaux sondages de Harris et du sondage de l'IFOP (réalisé à postériori), on a par exemple 21-21-23 selon Harris contre 24-24-22 selon l'IFOP : dans les deux cas, les marges d'erreur ne permettent de qualifier aucun candidat. Au passage, une autre marotte ne tient pas non plus, celle du nombre de jours ouvrés : les sondages évoqués dans cet article ont été réalisés en début, milieu ou fin de semaines sans effet apparent.

- La tournure des questions ?

Il existe une particularité dans les sondages d'opinion pour des échéances électorales : c'est que les questions sont rigoureusement les mêmes depuis des dizaines d'années.

Par exemple :

CSA : Si le premier tour de l’élection présidentielle avait lieu dimanche prochain et que vous ayez le choix entre les candidats suivants, pour lequel y aurait-il le plus de chances que vous votiez ?

IFOP : Si dimanche prochain devait se dérouler le premier tour de l’élection présidentielle, pour lequel des candidats suivants y aurait-il le plus de chances que vous votiez ?

Le biais redoutable : celui introduit par les journalistes

Selon Libération, "Le dernier sondage Ifop pour France Soir, publié jeudi, ne confirme pas la tendance donnée par les deux fracassants sondages Harris Interactive du week-end." De quelle tendance parle-t-on exactement ? Dans les faits, les résultats fournis par Harris Interactive évoquent un trio de candidats confinés entre 20 et 24%, affublés de marges d'erreur interdisant tout classement. De fait, avec le sondage de l'IFOP et la prise en compte des marges d'erreur, DSK arrive en tête. Mais l'écart entre Sarkozy et Le Pen est trop faible pour désigner un deuxième qualifié pour le second tour.

La page du sondage sur le site de l'IFOP le précise, d'ailleurs : "Les scores obtenus par Marine Le Pen conduisent aujourd’hui à une incertitude s’agissant de l’ordre d’arrivée des trois principaux candidats au premier tour dans les configurations dans lesquelles Martine Aubry et François Hollande sont testés face à Nicolas Sarkozy et à la Présidente du Front National."

Evidemment, ce genre de déclaration mi-figue mi-raisin ne saurait convenir à des journalistes qui se feront déjà violence d'utiliser le conditionnel dans leurs papiers. Pour autant, ne gagneraient-ils pas à lire les résultats d'étude fournis par les instituts de sondage ? D'autant que l'IFOP, ayant flairé les difficultés d'analyse, consacrait une page entière aux marges d'erreur dans son rapport ! En réalité, il est bien trop tentant de succomber aux sirènes du titre sensationnel. Or, embourbé dans son effet d'annonce, le journaliste se retrouve à jouer l'équilibriste entre la cohérence du propos et la réalité du rapport d'étude.

La parole est à la défense

Le buzz déclenché par le sondage Harris Interactive aura jusqu'à provoquer la venue de Jérôme Sainte-Marie (directeur de l'institut CSA), dans l'émission de Ruquier, samedi soir dernier. Cette petite demie-heure de télévision aura montré, d'une part, à quel point les directeurs d'institut se défendent extrêmement mal, et d'autre part, à quel point les journalistes commanditaires ne les aident décidément pas. Ainsi, on assiste piteusement à la dislocation d'une défense très peu préparée : en critiquant le sondage Harris Interactive, le directeur du département Opinion de CSA oublie qu'il scie la branche à laquelle il est difficilement agrippé. Et Ruquier, de résumer à la perfection : "je n'ai rien contre les sondages, je pense qu'il faut savoir les lire".

De fait, les directeurs ne sont pas les chargés de traitement, et je me rends bien compte, l'expérience grandissante, qu'ils ne sont plus les mieux placés pour défendre les méthodologies. Manque de temps, d'exposition ? Certainement pas : peu de secteurs d'activités peuvent se targuer de participer à des émissions de très grande écoute (sans compter, depuis 2007, les sept primes times consacrés à une élection).

Pour communiquer, les instituts devraient s'entourer de techniciens du sondage. Ils devraient également investir dans l'innovation, ce qu'ils ne font malheureusement pas assez : les pôles scientifiques des instituts sont peuplés d'ingénieurs pré-formatés à l'ENSAE ou à l'ENSAI, non aguerris à l'univers Internet et lorgnant dès leur arrivée sur des postes plus prestigieux. Pourtant, depuis le temps, comment les instituts ne se sont-ils pas rendus compte que la crédibilité du métier repose essentiellement sur les méthodologies employées, et qu'ils y gagneraient à communiquer plutôt qu'à se cacher derrière une norme ISO et quelques livres blancs, certes plutôt de qualité, mais passés malheureusement inaperçus ?

Moins de 5% des entreprises respectent les critères importants pour leur site

Moins de 5% des entreprises respectent les critères importants pour leur site TextMaster compte les fautes d'orthographe dans ses emails et en fait une étude

TextMaster compte les fautes d'orthographe dans ses emails et en fait une étude 5 exemples de l'impact d'une émission de télévision sur le trafic Web

5 exemples de l'impact d'une émission de télévision sur le trafic Web ElectionScope : que penser du modèle prédictif qui voit Sarkozy l'emporter ?

ElectionScope : que penser du modèle prédictif qui voit Sarkozy l'emporter ?

Commentaires

Encore un très bon article, on sent qu'il y a du travail derrière (merci pour le lien d'ailleurs) !

Je prépare justement un article sur les sondages d'opinion online avec un récapitulatif des attaques et des défenses.

Il est bon d'avoir rappelé ici que si les critiques existent (et elles sont nombreuses), elles sont, pour le moment, infondées (dans le sens qu'elles ne se basent pas sur de constats mesurés mais sur des "on pense que" ou des "c'est évident"...).

A cet égard, je conseille la lecture de l'article de Yves-Marie Cann de l'Ifop sur les sondages online et leur pertinence (http://www.ifop.com/media/pressdocu...) qui montre bien les bons résultats obtenus par l'online sur l'opinion.

Salut Guillaume,

Merci pour cet éclairage, mais j'ai une question qui est peut-etre bete: A quel moment doit-on considérer que la marge d'erreur est trop importante pour valider le résultat du sondage ? (quand cette marge atteint le score d'un des candidats?)

Tu fais remarquer qu'il est essentiel pour les journalistes d'étudier avant tout cette marge d'erreur. Soit! Mais dans bien des cas la marge d'erreur est trés élevée, cela ne rend-il pas pertinentes les analyses qui nient l'intérêt de tels sondages?

En bref faut-il publier les sondages qui comportent une telle marge d'erreur? Si oui, quelle est alors l'utilité de ces sondages ?

Merci (je constate que tu poursuis ta croisade contre certains journalistes)

Deivy froñ mexico

@Grégoire :

Merci pour tes compliments ! :-)

Et voici le lien vers l'article auquel tu fais allusion dans ton commentaire :

http://lemondedesetudes.fr/2011/03/...

@Deivy :

Dans le cas présent, les échantillons ont une taille d'environ 1000 individus (ou plus), ce qui est un standard pour ce type de sondage. La marge d'erreur ne dépassera donc jamais les +/- 3% ce qui est relativement peu pour un sondage évoquant une élection qui n'aura pas lieu avant un an et demi. Ce qui importe encore et toujours c'est la tendance : un sondage montrant que les marges d'erreur des trois principaux candidats à une élection se chevauchent est un résultat en soi, intéressant à analyser. Mais les journalistes ont un besoin irrépressible de départager les "ex-aequos".

Evidemment, ce genre de déclaration mi-figue mi-raisin ne saurait convenir à des journalistes qui se feront déjà violence d'utiliser le conditionnel dans leurs papiers.